Event | Cybersec Netherlands 2024

Op Cybersec Netherlands bracht Bart Preneel, cryptograaf en professor, een presentatie over ai en security. Met daarin ook twee doomscenario’s en drie vereisten om de toekomst van ai veilig te stellen. ‘Techbedrijven zouden sommige ai-toepassingen beter niet maken.’

Artificiële intelligentie dateert van midden vorige eeuw. ‘Maar in de jaren zeventig beleefden we een ‘ai-winter’. Om in de jaren negentig een doorbraak te krijgen met onder meer schaakcomputer Deep Blue’, vertelt Bart Preneel, hoogleraar aan de Belgische KU Leuven en diensthoofd van de gereputeerde Cosic-onderzoeksgroep (Computer Security & Industrial Cryptography).

Katten en honden

Een andere doorbraak voor ai – en best ironisch – was twaalf jaar geleden toen Google erin slaagde om via ai het verschil te zien tussen katten en honden. Intussen zijn we 2024 en is de ai-hype compleet. ‘Er is zelfs een Gartner Ai Hype Cycle, zo’n beetje de hype van de hype.’

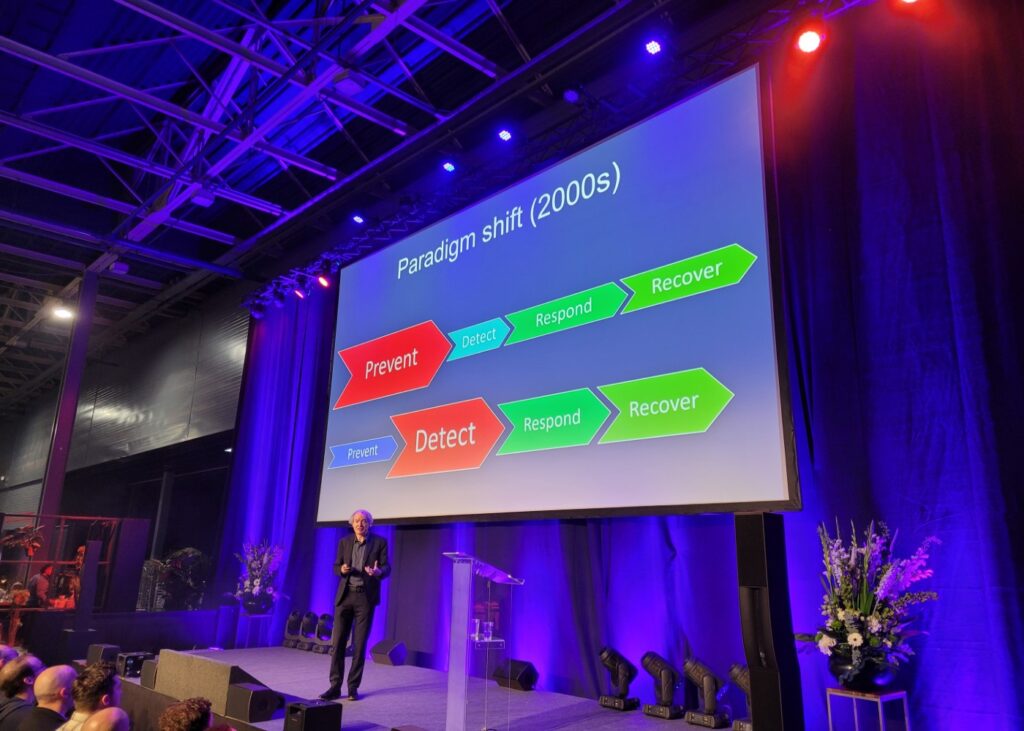

Wereldwijd zijn er achttien miljard iot-apparaten en tien miljard computers. Daar preventief op ingrijpen, is niet evident. ‘De focus is daarom verschoven van preventie naar detectie. Door ai toe te passen op incident data sets, kunnen we leren hoe de bad guys zich gedragen en hen de volgende keer sneller detecteren’, stelt hij.

Daarom helpt ai-cybersecurity flink bij detectie. ‘Dat gaat dan om detectie van malware, intrusion, kwetsbaarheden, fraude, phishing, dataverlies en de analyse van de zogenaamde side channels.’ Hierbij is uiteraard de vraag hoe betrouwbaar dit gebeurt. ‘Denk aan false positives of negatives.’ Tegelijk draagt cybersecurity bij aan ai. ‘Om de in- en output van een model maar ook het model zelf te beschermen.’

Ai-dystopia

De donkere kant van ai uit zich onder meer in het ontbreken van privacy en fairness. Preneel ziet twee doomscenario’s de ronde doen. ’Het eerste is ai-dystopia met catastrofale gevolgen voor de mensheid. Denk aan surveillance states, autonome killer drones of het verlies van menselijke autonomie.’

Het andere doomscenario luistert naar de naam ‘paperclipalypse’. Die verwijst naar een filosofische beschouwing waarbij ai met een taak als het maken van paperclips een Apocalyps zou kunnen veroorzaken door te leren steeds meer middelen aan deze taak te besteden. Waardoor het leert hoe het onze pogingen om die taak uit te schakelen kan weerstaan. ‘Hier gaat het om de angst van de mensheid om de controle over ai uit handen te moeten geven’, stelt Preneel. ‘Persoonlijk acht ik de kans op ai-dystopia groter dan die op paperclipalypse.’

Drie vereisten

Om in de toekomst correct met ai om te gaan, staan volgens Preneel drie zaken voorop. ‘Enerzijds is er de wetgeving. Het is goed dat er een ai-act is, al is het maar voor het bewustzijn. Maar het is niet voldoende. Ook omdat er nog veel gaten en valkuilen aan zijn verbonden’, stelt hij. De tweede vereiste is alertheid rond het ethische aspect. ‘Studenten moeten dat in hun opleiding meekrijgen. Dat gebeurt nu vaak niet.’

En ten slotte is er de technologie zelf. ‘Want de ai-evolutie gaat alsmaar sneller. En ai-bedrijven willen vandaag vaak de snelste zijn. Maar techbedrijven moeten zich ervan bewust zijn dat zij sommige toepassingen beter niet kunnen maken en uitbrengen. Het principe van ‘move fast and break things’ is in het geval van ai geen goed idee. Als je niet de exacte gevolgen kan inschatten, rol je je technologie best niet uit’, vindt Preneel, en hij plaatst het zelfs in historisch perspectief. ‘Vorige eeuw zijn fysici pas gaan nadenken over de impact van hun wetenschap nadat de atoombom is gevallen. Dat risico nemen we met ai beter niet.’