BLOG – Het afgelopen jaar zagen we grote taalmodellen (llm’s) die nieuwe mogelijkheden ontsluiten met generatieve ai (gen-ai). Sindsdien ontwikkelen bedrijven haastig een ai-strategie om mee te liften met deze krachtige nieuwe technologie. Echter, met zoveel focus op wat ze met ai kunnen doen, zijn veel bedrijven traag in het nadenken over hóe ze dat zouden moeten doen. En specifiek, hoe dit de vereisten voor het datacenter verandert?

Voor de eenvoud ga ik ervan uit dat er geen overweging is om een eigen datacenters te benutten maar om een datacenter van derden oftewel co-locatie te gebruiken. Onder invloed van duurzaamheidseisen en kostenoptimalisatie zien we de beweging weg van het eigen datacenter als duidelijke trend. Ook ga ik ervan uit dat vanwege privacy en databescherming de optie publieke ai is afgewezen en dat er gezocht wordt naar een private ai-oplossing.

Voorheen waren er twee hoofdcategorieën: algemene colocatiedatacenters gelegen op willekeurige locaties en colocatie-datacenters met hoge netwerkdichtheid (interconnectie) gelegen op locaties in dichtbevolkte gebieden. Maar voldoet deze indeling nog voor ai-workloads?

Wie kiest voor colocatie-datacenters, doet dit vaak op basis van kosten en efficiëntie, met minimale operationele kosten voor vastgoed en energie, zelfs als dit betekent dat dit ten koste gaat van de netwerkdichtheid. Maar het kan juist waardevol zijn bepaalde workloads op specifieke locaties te draaien, zoals bij netwerkdichte locaties in grote stedelijke gebieden. Hoewel datacenters met sterke interconnectie duurder kunnen zijn, compenseren ze dit met zakelijke voordelen. De locatie van je infrastructuur is belangrijk als je ai wilt optimaliseren, dus moeten we onze kijk op datacenters bijstellen.

Datacentersegmentatie in het ai-tijdperk

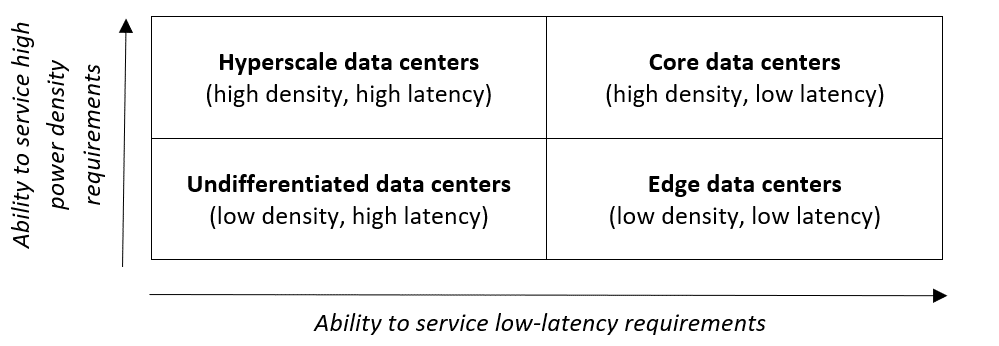

Wat ai anders maakt voor het datacenter zijn de strenge eisen voor power density, die gepaard gaan met de nieuwe generatie gpu-chipsets. Als we power density als tweede dimensie voor segmentatie toepassen, eindigen we met een eenvoudige matrix zoals hieronder. De verticale as loopt van lage tot hoge density, terwijl de horizontale as van hoge naar lage latency loopt.

Op basis van deze – versimpelde – grafiek onderscheiden we vier basissoorten datacenters:

- Ongedifferentieerde datacenters

De meeste datacenters zijn ongedifferentieerd en gebouwd zonder focus op netwerkdichtheid, bijvoorbeeld omdat ze dicht bij het personeel zitten; zoals kantoorgebouwen of omgebouwde magazijnen. Hoewel dit type geschikt is voor bepaalde workloads, lopen bedrijven die op deze datacenters vertrouwen voor hun ai-strategieën risico. Als de eisen aan stroomdichtheid toenemen, kunnen upgrades voor koeling en stroom een probleem gaan vormen. Dat bemoeilijkt de inzet van ai.

- Hyperscale-datacenters

Hyperscale-datacenters zijn ideaal als je zeer hoge stroomdichtheid nodig hebt, maar minder eisen hebt wat betreft latency. Ze worden traditioneel gebruikt door grote cloud- en ‘as-a-service’-providers. Bedrijven verkrijgen binnen deze datacenters capaciteit op basis van pay-as-you-go, zonder zelf nieuwe apparatuur met hoge energie-consumptie te installeren. Deze datacenters worden vaak geassocieerd met LLM-trainingsworkloads in ai, die veel energie consumeren en rekenintensief zijn maar minder gevoelig zijn voor latency. Toch is niet elke trainingsworkload exclusief geschikt voor hyperscale datacenters. Het kiezen van de juiste locatie voor ai-workloads vereist nuance.

- Edge-datacenters

Edge-datacenters, in de buurt van clusters van gebruikers en applicaties, garanderen lage latency voor specifieke workloads. Hun stroomdichtheidseisen groeien minder snel dan bij andere segmenten, omdat ze voornamelijk netwerkintensieve en minder rekenintensieve workloads ondersteunen. Ze zijn geschikt voor ai-inferentie (het toepassen van een eerder gebouwd ai-model) met lage latency, zoals gaming of virtuele assistenten. Bedrijven moeten beslissen of ze ai-inferentie in edge datacenters plaatsen of dat ze deze behoeften centraliseren in meer gevestigde hubs, met betere uitbreidings- en interconnectie-mogelijkheden. Uiteraard is dit afhankelijk van de mate van latency die de applicaties kunnen verdragen.

- Core-datacenters

Core-datacenters vormen de basis van moderne digitale infrastructuur. Ze bevinden zich doorgaans op locaties waar netwerkdichtheid en nabijheid van gebruikers de beste mogelijkheden bieden voor leveranciers en gebruikers van technologie. Hier wordt ook de toegang naar de cloud geleverd. Als het gaat om ai, dan zijn core datacenters doorgaans niet de meest geschikte plek om grote taalmodellen te trainen. Dat doe je eerder op hyperscale-sites, waar hoge stroomdichtheid wordt geleverd tegen een bepaalde kostprijs per rekencyclus. Maar als het gaat om ai-inferentie, dan zijn core datacenters juist uitermate geschikt, vanwege hun nabijheid tot andere databronnen en de lage latency-toegang die ze aan gebruikers, apparaten en applicaties bieden.

Ai-infrastructuurstrategie

Niet alle trainingsworkloads zijn groot genoeg om terecht te komen in hyperscale-faciliteiten. En er zijn inferentieworkloads die niet gevoelig genoeg zijn voor latency om terecht te komen op edge-locaties. We verwachten dat bedrijven afwegingen maken voor hun trainingsvereisten tussen hyperscale- en core-locaties en kiezen tussen edge- en core-locaties voor hun inferentieworkloads.

Veel bedrijven willen de enorme datasets die benodigd zijn voor ai snel tussen gedistribueerde locaties kunnen verplaatsen. Hiervoor is een sterke netwerkinfrastructuur belangrijker dan ooit. Core-datacenters bieden eenvoudig toegang tot ecosystemen van netwerkserviceproviders en vormen daarmee de ideale basis voor bedrijven die hun omgeving moderniseren.

Johan Arts is senior vice president sales EMEA bij Equinix