Artificial intelligence (ai) heeft de potentie om binnen vijf jaar het cybersecuritylandschap op zijn kop te zetten. Als cyberbeveiligers niet snel stappen zetten, is de kans groot dat de digitale infrastructuur tussen nu en 2028 onvoldoende valt te beschermen.

Dit blijkt uit de toekomstvisie die TNO samen met ABN Amro, Achmea, ASML, Belastingdienst en ING heeft opgesteld. Hieraan gekoppeld was de ontwikkeling van een ai-raamwerk dat beveiligingsexperts helpt hun taken beter te verrichten,

In het project PurpleAI bekijken de onderzoekers van het Partnership for Cyber Security Innovation (PCSI) hoe ontwrichtend ai kan werken. Ze bereiden zich voor op een tijdperk waarin zowel de aanvallers als verdedigers ai toepassen.

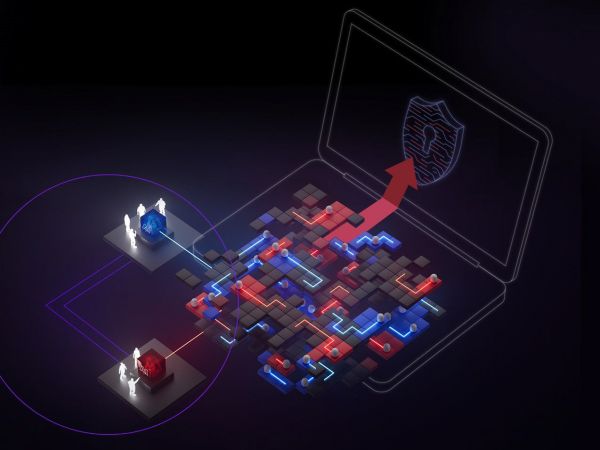

Red en blue teams

Centraal stond de vraag of het mogelijk is een systeem te ontwikkelen dat een it-omgeving simuleert waarin machine learning zowel de zogenaamde red teams als de blue teams helpt zich continu te verbeteren. Red teams, zoals pentesters en ethische hackers, zoeken naar kwetsbaarheden in de infrastructuur die ze moeten beschermen. Ze kruipen als het ware in de huid van aanvallers die gebruik maken van (generatieve) ai. Door deze tegenstanders voor te zijn kunnen ze gevaren afwenden.

De blue teams (soc’s, incident responders en threat intelligence teams) kunnen overgaan tot het gebruik van ai om hun verdediging te automatiseren. Helemaal mooi zou zijn als ai-software een flink deel van hun werk kan overnemen en zelfstandig te werk kan gaan. Het samenspel tussen beide teams wordt ‘purple teaming’ genoemd.

Leermodel

In het project PurpleAI ontwikkelden TNO en zijn partners een raamwerk voor een systeem waarin machine learning de prestaties van beide teams continu verbetert. Dit raamwerk bestaat uit twee componenten: een reinforcement learning-model en een simulator. Het leermodel leert welke volgorde van acties het beste kan worden genomen. De simulator imiteert het gedrag van een digitale omgeving, bijvoorbeeld een Windows-desktop.

De onderzoekers kwamen tot de eerste implementatie van een proof of concept. Experimenten bewezen dat het model de juiste stappen kan leren zetten als het gaat om ‘privilege escalation’ in een vereenvoudigde setting. De onderzoekers zien meerdere kansen voor toepassing en verdere uitbreidingen van het raamwerk. De volgende stap is deze technologie in een echte omgeving in de praktijk te brengen. Zo ver is PurpleAI nog niet gekomen.

Drie disciplines

De onderzoekers roepen de cybersecurity-industrie op om zich nu voor te bereiden op een tijdperk van kwaadaardig gebruik van ai voor cyberaanvallen. Ter voorbereiding daarop moeten we in drie verschillende disciplines ontwikkelen. Ten eerste moeten we defensieve ai- en ml-systemen adopteren en de vereiste vaardigheden en processen ontwikkelen om ze effectief te gebruiken. Daarnaast moeten red teams ai inzetten om de infrastructuur-stresstests te laten ondergaan tegen realistische, op ai gebaseerde aanvallen. Ten slotte is verder onderzoek nodig naar de beste verdediging met ai tegen op ai gebaseerde aanvallen.