De Open Universiteit heeft dr. Natasha Alechina benoemd tot hoogleraar safe and responsible ai bij de faculteit Bètawetenschappen. De in Moskou afgestudeerde filosoof begint per 1 september. De leerstoel zal onderzoek en onderwijs op het gebied van ai ontwikkelen. Dit is een technisch onderzoeksgebied gericht op het gebruik van algoritmen en modellen voor taken als geautomatiseerde besluitvorming, machinaal leren en redeneren door intelligente systemen.

Als leerstoelhouder kijkt Natasha Alechina naar de technische aspecten die nodig zijn voor veilig en verantwoord gebruik van ai. Het is volgens haar belangrijk dat studenten de maatschappelijke en ethische implicaties van ai leren begrijpen. Bij de ontwikkeling van het masterprogramma moet volgens Alechina goed voor ogen worden gehouden dat de studenten nu al de kennis krijgen die ze nodig hebben als toekomstige ai-specialisten. Daarnaast vindt Alechina dat studenten moeten worden aangemoedigd om te discussiëren over de maatschappelijke implicaties van ai. Ze moeten in staat worden gesteld het mediadiscours over ai kritisch te analyseren en kunnen bijdragen aan de discussie over het overheidsbeleid inzake ai.

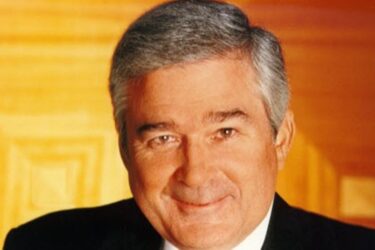

Alechina studeerde in 1986 cum laude af in Filosofie en promoveerde vervolgens op Probabilistic Semantics and Inductive Logic aan de staatsuniversiteit van Moskou. Daarna promoveerde zij in 1995 met het proefschrift ‘Modal Quantifiers’ aan de Universiteit van Amsterdam binnen de faculteit Wiskunde en Informatica. Zij werkte 23 jaar lang in Engeland. Sinds 2019 werkt Alechina als universitair hoofddocent aan de faculteit Bètawetenschappen aan de Universiteit Utrecht.

Haar onderzoek richt zich op logica en haar toepassingen in ai en computerwetenschap, met de nadruk op het ontwerpen van veilige en correcte agentprogramma’s en multi-agent-ai-systemen.

Alsof logica iets van doen heeft met (kunstmatige) intelligentie.

@Jack Vraag me het af. Kan niet achter de schermen kijken maar ik denk dat veel AI simpel gezegd om patroonherkenning gaat. (Als het anders zit hoor ik het graag!) Er zullen ontwikkelingen komen waar logische redeneren een rol speelt. Dat is nu juist een van de dingen waar ik benieuwd naar ben. Kwam het al tegen in een artikel, als een van de ontwikkelingen. Zou toch mooi zijn als je aan de computer kan vragen: wat doen wij jij hier? Of dat het ding er zelf mee op de proppen kan.

Geautomatiseerde besluitvorming, machinaal leren en redeneren door intelligente systemen klinkt als een platgeslagen logica welke begrijpbaar is voor computers. Typisch dat Jack die ons altijd naar zijn één dimensionale beslissingstabellen verwijst opeens stelt dat de voorspelbaarheid op basis van een logische redenatie niks met intelligentie te maken heeft.

To be or not to be komt dan ook de vraag op of Jack wel Jack is want het zou zomaar een grapje van Dino kunnen zijn.

Beslissingstabellen zijn 1-dimensionaal als je ze datagedreven (en/of regelgedreven) verwerkt. En 4-dimensionaal (namelijk ruimte x tijd) als je ze doelgedreven verwerkt. Dat laatste heeft mijn voorkeur, omdat menselijke intelligentie altijd doelgedreven (en bovendien zin- en waardegedreven) is.

De enige werkende oplossing voor deze challenge sinds maart 2019 is dan ook met beslissingstabellen en een doelgedreven aanpak: https://dmcommunity.org/challenge/challenge-march-2019/

Shall we play a game van de film Wargames kwam hier al eerder ter sprake, het doel van winnen tegen elke prijs gaat nu eenmaal om de logica van dingen tegen elkaar afstrepen. Want goed en kwaad kun je de wijsheid niet uit het ongerijmde fantaseren zoals de wijsbegeerte leert. De oproep om de maatschappelijke en ethische kant meer te belichten gaat tenslotte meer om de rechtvaardiging van de middelen dan het doel.

We hebben een hamer en daarom is alles een spijker mis ik bij Jack nog de filosofie want de vervanging van de mens door een algortime mist de empatie van inleving (zijn) en begrip (tijd). Oftewel: “Four legs is good, two legs is better” om af te sluiten met een cryptogram.

“Zou toch mooi zijn als je aan de computer kan vragen: wat doen wij jij hier? Of dat het ding er zelf mee op de proppen kan.”

Wij zijn op aarde om God te dienen en daardoor hier en hiernamaals gelukkig te zijn.

Maar wellicht kun je je vraag insturen voor https://dmcommunity.org/challenge/challenge-july-2023/

Er zitten extra veel ethische aspecten aan AI. AI systemen zijn vooral gericht op correlatie vanuit de statistiek en niet op causale verbanden en logische redenering. AI-systemen worden met algoritmes getraind om patronen en correlaties te herkennen bij soms enorme hoeveelheden trainingsdata, die statistische uitkomsten opleveren. If it looks like a duck, swims like a duck, and quacks like a duck, then it probably is a duck. AI-systemen kunnen verkeerde conclusies trekken wanneer correlaties niet gelijk opgaan met causale verbanden. De toename van ooievaars en mensen is geen bewijs dat ooievaars kindertjesbrengers zijn. AI moet aan de hand van cases en correcties door trainers op niveau gebracht en verbeterd worden. Uiteindelijk kan AI sneller en beter herkennen dan een mens doordat het geen last van concentratieproblemen heeft en om een second opinion van de mens kan vragen. Voorbeeld hiervan is het herkennen van afwijkende structuren en cellen bij medisch onderzoek. Maar AI kent niet alle mogelijke varianten en gebruikt geen harde achtergrondinformatie en kan dus gevaarlijke fouten maken. Een bekend voorbeeld hiervan is een zelfrijdende Uber-auto die een overstekende voetgangster heeft overreden omdat deze een fiets bij zich had. Het autonome systeem had deze situatie niet herkent. Mensen zouden gaan twijfelen en nogmaals kijken, maar AI is meestal ingesteld om voort te denderen.

Discriminerende algoritmes hebben in Nederland voor enorm veel ellende en extra kosten gezorgd. Als AI beslissingen neemt, dan is de redenering achter de resultaten moeilijk of niet te begrijpen door een gebrek aan transparantie bij de algoritmes en de interpretatie van de basisgegevens. Foute ambtenaren vervangen door foute systemen, lijkt me geen oplossing. En wie is verantwoordelijk voor de fouten? Vanwege de controleerbaarheid, moet het AI systeem zo gebouwd worden dat het kan aangeven waarop beslissingen zijn gebaseerd, anders wordt ons rechtssysteem genegeerd.

ChatGPT is machine learning AI en gebruikt natuurlijke taalverwerking; een principe dat nog is bedacht door Alan Turing. Maar 6 decennia later snapt ChatGPT nog steeds niks van je vraag of van het gegeven antwoord. Door gigantisch veel informatie door te spitten koppelt het systeem een verzoek aan een respons die zeer waarschijnlijk bij het verzoek hoort. Dat doet ChatGPT overigens heel veel beter dan meeste chatboxen. Maar wat is de inhoudelijke kwaliteit van de respons? ChatGPT komt met nogal algemene antwoorden die ook wel eens vaag zijn en mij weinig nieuwe inzichten opleveren. Herhaal je de vraag, dan komt er een iets afwijkend antwoord en de vraag welk antwoord het beste zou zijn. Echt foute antwoorden kom ik zelden tegen. Welke informatie ChatGPT gebruikt wordt niet duidelijk aangegeven, maar het zal wel gebaseerd zijn op denkbeelden van de heersende stroming. Die heeft het statistisch vaker bij het rechte eind, al kan ook de mainstream op de korte termijn zeer foute keuzes maken. Het antwoord van ChatGPT zal daardoor vooral bestaan uit een samenvatting van enigszins gedateerde mainstream bevindingen, analyses en meningen, inclusief de mainstream vooroordelen bij de trainers. Natuurlijk weten experts het beter, maar worden zij met hun denkbeelden betrokken, zoals vroeger bij het samenstellen van encyclopedieën? ChatGPT zelf blijft hierover vaag. ChatGPT geeft overigens aan geen toegang te hebben tot Natasha Alechina’s publicaties.