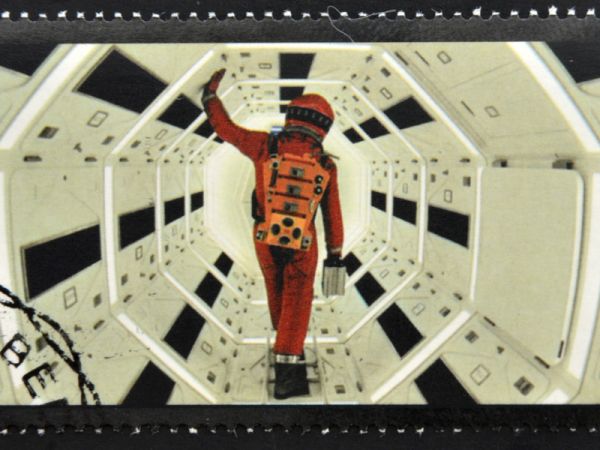

Het klinkt als iets uit de sciencefictionfilm 2001: A Space Odyssey (1968), waarin de boordcomputer HAL 9000 het commando over een ruimtemissie naar zich toetrekt. Maar ook de realiteit van nu is dat kunstmatige intelligentie kan ontsporen en een eigen leven gaat leiden.

Een klassiek voorbeeld is de chatbot Tay, die werd getraind aan de hand van de commentaarvelden van internet en vervolgens precies deed wat er in een commentaarveld allemaal gebeurt. En dat was niet fraai. Er is geen gebrek aan andere voorbeelden, want als artificiële intelligentie (ai) op het verkeerde pad terechtkomt, haalt het bijna altijd wel het nieuws. Hoewel deze publieke aandacht voor slecht presterende ai tegelijk afschrikwekkend als vermakelijk kan zijn, is het belangrijk om een minder voor de hand liggend risico niet uit het oog te verliezen: ai-ongelukken. Wat zijn dit precies en wat kun je doen om ze te voorkomen?

Op hol

Er zijn er twee manieren waarop een ai-ongeluk kan ontstaan. Je hebt ai die per ongeluk op hol slaat, terwijl je nog in het bouwproces zit. Je bent in dit geval bewust met de ai bezig en dus ook bewust van wat er fout kan gaan.

Je hebt ook ai die ontspoort terwijl je niet wist dat je ai aan het bouwen was. In dit geval was je iets anders, misschien minder riskant, aan het bouwen, en op het moment dat het misgaat, kom je erachter dat je een losgeslagen ai hebt gebouwd.

Wanneer je al ervaring hebt met het bouwen van enigszins complexe ai lijkt het misschien vreemd dat zulke ongelukken kunnen gebeuren. Projecten beginnen toch altijd met goed gedefinieerde bedrijfsbehoeften? En de modellen worden toch getraind en vergeleken? Hoewel dat misschien waar is voor ai die vanaf het begin op een collaboratieve manier wordt gebouwd in een platform, is dit zeker niet altijd de manier waarop ai tot stand komt.

Ai bouwt voort op dezelfde schema’s die machine learning tientallen jaren geleden introduceerde, zoals bijvoorbeeld de klassieke regressietechnieken. Het verschil zit hem in de schaal en de complexiteit van beide methoden. De basisproblemen zijn niet verdwenen. Extrapolatie buiten het trainingsbereik blijft problematisch. Er zijn soms te weinig trainingsgegevens om een statistisch deugdelijk model te krijgen, en correlatie versus causatie-problemen belemmeren de interpreteerbaarheid van de verkregen data. Dit is goed terug te zien in de volgende twee voorbeelden.

De bank

Een bank in Midden-Europa had een risicomodel nodig om te slagen voor stresstests. Deze stresstests worden uitgevoerd om na te gaan hoe goed banken financiële en economische schokken kunnen weerstaan. Het model dat zij gebruikten, begon twintig jaar geleden als een op regels gebaseerd systeem. Tien jaar geleden voegde de bank meer variabelen toe waarmee het model rekening moest houden, samen met meer databronnen. Het model werd door de toezichthouders ‘conform’ bevonden voor het doel waarvoor het was ontworpen. Daarnaast ontstond er door deze ontwikkeling een nieuwe databron die een nieuwe geaggregeerde weergave van de balans van de bank liet zien. Dit werd op zijn beurt de bron van meer geavanceerde modellen om de liquiditeitslimieten te bewaken. Maar de onderliggende vereisten voor een op regels gebaseerde aanpak zijn niet hetzelfde als de vereisten voor geavanceerde modellen. En omdat de basis niet geschikt was, begon het geavanceerde model plotseling en onverwacht slechte prestaties te leveren.

De farmaceut

Een farmaceutische fabrikant worstelt met een voorspellingsmodel voor de verkoop. Terwijl het voor sommige regio’s de verkoop nauwkeurig voorspelt, zit het er voor andere regio’s altijd (maar onvoorspelbaar) naast. Dit maakt het voor het verkoopteam lastig doelstellingen te bepalen en te presteren, met als gevolg dat enkele medewerkers het bedrijf zelfs verlaten.

Het model werd gebouwd door één enkele expert, opgeslagen en uitgevoerd op zijn laptop. Toen deze expert het bedrijf verliet, werd het model overgedragen aan anderen, maar iedereen is te bang om het aan te raken. Hoewel het model duidelijk geïdentificeerde vooroordelen heeft, draait het vandaag de dag nog steeds. Waardoor er bij de farmaceut twijfelachtige besluitvorming plaatsvindt en de onvrede erover niet wordt opgelost.

In beide gevallen ontstond opeens een ai-oplossing waar voorheen geen rekening mee was gehouden. Hoewel er bij een groot deel van de betrokkenen geen intentie was ai toe te passen, vonden er op een gegeven moment wel ai-ongelukken plaats.

Waarschuwingssignalen

Onbedoeld gedrag is niet wenselijk, omdat het kan leiden tot verkeerde, onnauwkeurige of zelfs gevaarlijke uitkomsten. Ongelukken kunnen niet alleen gebeuren met chatbots zoals Tay, maar met alle andere soorten ai. En voor het model zelf maakt het niet uit dat het fout is, maar voor het bedrijf, regelgevers en gebruikers wel. Een losgeslagen ai kan leiden tot risico’s, compliancy-problemen en concurrenten die eerder op trends inspelen, maar ook tot geldverlies of erger. Maar er zijn waarschuwingssignalen voor ai-ongelukken.

Wanneer modellen met een bepaald doel voor andere doeleinden worden gebruikt, moet er een (alarm)belletje gaan rinkelen. Zelfs eenvoudige op regels gebaseerde modellen kunnen, wanneer zij verkeerd worden gekoppeld, nieuw gedrag gaan vertonen dat we alleen van meer geavanceerde systemen zouden verwachten (zoals bij het voorbeeld van de bank). En hoewel hergebruik de norm zou moeten zijn, zijn zorgvuldige controlesystemen een must om dit robuust te maken.

Ook modellen die begonnen als een persoonlijk project om, met de beste bedoelingen, een concrete vraag van reëel zakelijk belang te helpen beantwoorden, moeten in de gaten worden gehouden. Dit soort modellen worden al snel ondoordringbaar wanneer de bedenker is vertrokken of doordat niemand in twijfel durft te trekken wat altijd heeft gewerkt. Het onderscheid is hier niet de gebruikte methode, maar de mate waarin cruciale beslissingen worden gedelegeerd aan een geautomatiseerd systeem. Zeker wanneer dit gebeurt zonder bewust de afwegingen te maken en de gevolgen in het oog te houden.

Als laatste is het belangrijk om te kijken naar bedrijfseigen black-box-modellen die voor een bepaald doel bij derden zijn gekocht. Bijvoorbeeld wanneer een organisatie een tool koopt om cv’s mee te screenen. Op het eerste oog heeft dit niks met AI te maken, maar vanuit het oogpunt van veel regelgevers is deze organisatie aan een ai-reis begonnen waarvan ze de bestemming en het voertuig niet kennen. Aangezien de precieze aannames, training en vooroordelen die in deze black-box zijn verwerkt niet bekend zijn, is het lastig om zeker te weten dat het model goed gebruikt word. Dus je werkt misschien al met modellen die worden gebruikt buiten het bereik waarvoor ze zijn ontwikkeld – bewust of onbewust.

Als deze signalen zich voordoen, is het zaak in actie te komen. Maar ook hier is voorkomen beter dan genezen. Daar ga ik hier in een tweede deel dieper op in.