Recentelijk werpt de vrijemarktwerking vragen op. Moeten onafhankelijke (overheids)instanties meer invloed kunnen uitoefenen op bedrijfssectoren om het algemeen belang te beschermen? Een kwestie die ook relevant is binnen ons internetvakgebied, waar we duidelijk de verschuiving zien van industrie-standaarden naar vendor-gedreven standaarden.

De vraag die zich allereerst aandient, is of die verschuiving een vloek of een zegen is. Instanties als de Internet Engineering Task Force (IETF) houden zich al decennia bezig met het bedenken, evalueren en invoeren van standaarden. Deze onafhankelijke instanties hebben belangrijke, wereldwijd geaccepteerde normen op hun palmares via een bottom-up-benadering waarbij concurrentie samenwerkt om tot een standaard te komen. Het request for comments-proces (afgekort tot rfc) om tot nieuwe normen te komen via zo’n industry body is lang – en vaak pijnlijk – omdat:

- Het gaat om beslissingen voor de lange termijn die breed gedragen moeten worden. Kijk bijvoorbeeld naar irc (internet relay chat, een oude standaard die onder techneuten nog steeds gebruikt wordt) en naar rfc 1149, ‘a standard for the transmission of ip datagrams on avian carriers’. Deze rfc omschrijft minutieus het versturen van e-mail per… postduif.

- Veel eigenwijze en knappe koppen vanuit verschillende expertises zullen er altijd wel een mening over hebben. Dit kan tot langdurige discussies leiden. Vanwege verschillende inzichten, maar ook vanwege de granulariteit waarmee die discussies plaatsvinden. Techneuten hebben, zeker in discussies over standaarden, de neiging alle mogelijke scenario’s uit te werken en af te vangen. Vinton Cerf, maar vaak ook relatief onbekende namen, zoals Joyce K. Reynolds en Jon Postel stonden met hun bijdragen aan de basis van internet.

De grondigheid van een rfc-procedure komt de robuustheid van de standaard vrijwel altijd ten goede en is geen overbodige luxe.

Geaccepteerd

Een nadeel van deze benadering is dat het vaak lang duurt voordat een nieuwe standaard wordt geaccepteerd. Deze lange ‘time to market’ is niet in het belang van techgiganten voor wie de mogelijkheden die internet ze biedt, de basis vormen van hun bedrijfsmodel. Hoe meer nieuwe diensten ze kunnen uitrollen, des te meer ze kunnen verdienen. Dus ontwikkelen deze bedrijven hun eigen vendor-standaarden, die – als ze breed gedragen worden – geaccepteerd worden door de hele markt. Het S3-protocol voor objectopslag is hiervan misschien wel het bekendste voorbeeld. Dankzij de relatief korte ontwikkeltijd kan een grote groep gebruikers – veel sneller dan bij een industriestandaard – gebruikmaken van nieuwe diensten om hun eigen bedrijfsvoering te verbeteren. Wel kleven er drie belangrijke nadelen aan:

- Omdat ze relatief snel worden gelanceerd, zijn deze vendor-gedreven standaarden vaak een work in progress;

- Aanpassingen zijn afhankelijk van de grillen van de vendor;

- De toepassing van een vendor-standaard verschilt per vendor, of beter hyperscaler, en er is geen of beperkte interoperabiliteit. S3-‘compatible’ producten bijvoorbeeld, lopen altijd achter de realiteit aan.

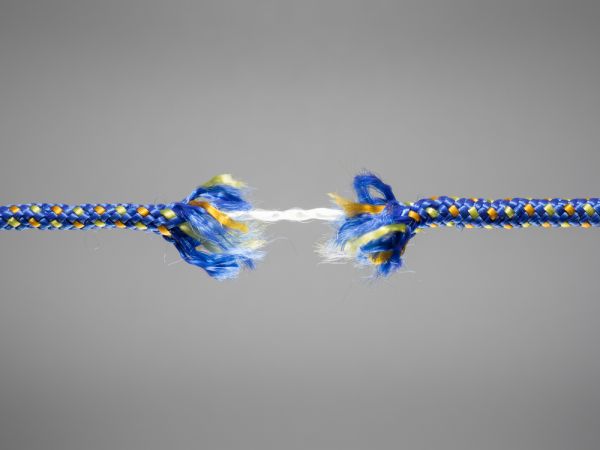

Deze punten zorgen ervoor dat deze manier om standaarden te ontwikkelen in eerste instantie niet lijkt te passen bij het GAIA-X-initiatief om tot een Europese cloud te komen, waarbij interoperabiliteit een kernvoorwaarde is. Grappig genoeg is het probleem dat hier wordt opgelost voor een deel veroorzaakt door die gesloten ‘vendorstandaarden’. Tegelijkertijd ontkomen we er niet aan dat de markt onderhevig is aan een sterk voorwaartse druk die weinig op heeft met weerstand in de vorm van lange standaardiseringsprocessen.

Traagheid

Er is, zover ik kan beoordelen, geen makkelijke oplossing om het spanningsveld tussen industrie-gedreven en vendor-geïnitieerde standaardisatie weg te nemen. Daarom moeten we kijken naar nieuwe manieren om het internet te verbeteren via open industrie-standaarden. Te denken valt aan het met consensus promoveren van vendor-standaarden naar industrie-standaarden of aan het vereenvoudigen van het rfc-proces van de IETF. Met betrekking tot dat laatste verwacht ik niet dat we helemaal ontkomen aan de ‘traagheid der dingen’ vanwege het vele-ogenprincipe dat de Task Force hanteert. Maar of dat per se slecht is?

Een de facto standaard is de feitelijke norm die een dominante positie heeft verworven door aanvaarding van de markt of door marktkrachten, bijvoorbeeld omdat het een open standaard is die eenvoudig geadopteerd kan worden waardoor acceptatie als standaard versneld wordt. Simpel gezegd, kom met oplossingen want marktwerking gaat om het brengen van innovatie waarbij reversed engineering voor de ‘compatible’ producten zorgt. Het beter goed gejat dan slecht bedacht scheelt namelijk in de ’traagheid der dingen’ bij het opnieuw uitvinden van het wiel.

Het probleem is dat voorstanders van het ene of het andere beleid gaan cherry-picken op praktijkincidenten. Om een zevental redenen is dat zo’n beetje de slechtste methodiek om je beleid op te baseren. Andere organisatiesystemen presteren statistisch beter op voorspellend vermogen. Beleidskwaliteit is recht-evenredig met het voorspellend vermogen van een organisatiesysteem. Superbelangrijk is dat je de markt van onderaf laat selecteren. Standaards hebben niet alleen voordelen. Er zijn soms urgente redenen waarom ergens geen standaard van ontstaat. Als alles autonoom rijdt, kan links of rechts rijden totaal onbelangrijk worden en nog jaren voor niet-optimale verkeersinfrastructuren zorgen. De standaard houdt zichzelf in stand omdat marktpartijen van het gegeven uitgaan en zien geen reden om bijvoorbeeld op handshake-protocollen te standaardiseren waarbij je gewoon links kunt gaan rijden als je links af slaat en dan op het linker baanvak blijft. Standaards kunnen bijzonder fnuikend werken op innovatieve dynamiek zonder dat je er achteraf de vinger op kunt leggen.