Het is onderzoekers van de University of Michigan in de VS gelukt om memristors bovenop een standaard CMOS te bouwen om te demonstreren dat een dergelijk systeem werkt om kunstmatige intelligentietaken uit te voeren.

De memristorbelofte bestaat al jaren en langzaam lijken daadwerkelijk toepassingen steeds toegankelijker te worden. Bij een memristor worden computationele taken direct op het geheugen uitgevoerd, zonder eerst vanuit het werkgeheugen naar een cpu te moeten. Hierdoor kan de snelheid van berekeningen toenemen, de totale energiebehoefte afnemen en daarmee kan memristortechnologie een belangrijk onderdeel worden van de toekomstige kunstmatige intelligentiebehoefte.

Schuiven met data

Tot nu toe werden memristors vooral gebouwd voor heel specifieke problemen, waarbij het totale ontwerp van de chip daarop aangepast is. De onderzoekers uit Michigan laten nu de eerste, op memristors gebaseerde programmeerbare computer zien voor kunstmatige intelligentie (ai) die geheel zelfstandig kan werken.

Leermodellen voor ai worden steeds groter en daarmee is de hoeveelheid data die verplaatst moet worden tussen geheugen en de processor voor de verwerking van al die modellen ook steeds groter. Het steeds heen en weer schuiven van die data van en naar het geheugen kost tijd en energie en dat kan bij een memristor dus achterwege blijven.

Ruim anderhalf jaar geleden kwam hetzelfde lab ook al in het nieuws met het gebruik van memristors om neurale netwerken context te laten begrijpen of recurring neural networks waarbij de memristors een soort kortetermijngeheugen vormen. Een belangrijk voordeel van memristors is ook dat ze meer analoog kunnen functioneren dan normale, binaire computerchips.

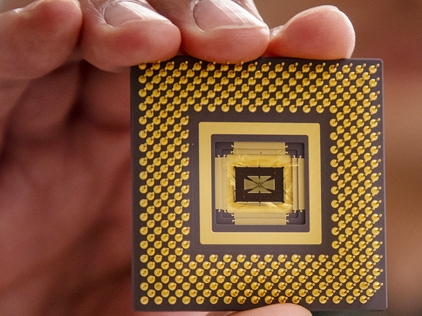

Het nu geproduceerde demonstratiemodel van de chip bestaat uit een array van 5832 memristors met een OpenRISC-processor. Op de chip zitten verder 486 digitaal-naar-analoog-converters en 162 analoog-naar-digitaal-omzetters, samen met twee mixed-signal interfaces die als ‘vertalers’ optreden tussen de analoge berekeningen van de memristors en de hoofdprocessor van de chip.

Machine learning

De chip is nog wel betrekkelijk traag in vergelijking van wat ‘normale’ ai-versnellerchips kunnen bereiken. Dit komt onder andere doordat de chip gebouwd is met een 180-nanometer procede in plaats van nu meer gangbare maten ruim onder de 20 nanometer. De door het lab gebouwde chip kan 188 miljard berekeningen per seconde per watt aan, terwijl de nieuwste ai-versnellerchips van bijvoorbeeld Nvidia 9,09 biljoen berekeningen per seconde per watt aankunnen. Als de afstanden tussen de transistors verkleind kunnen worden tot zo’n 40nm, dan zou de chip al zo’n 1,37TOPS/W moeten kunnen leveren, zonder data eerst uit een werkgeheugen te moeten halen.

Zo ver is het nog niet, maar deze chip is dan ook hoofdzakelijk als onderzoeksobject bedoeld om aan te tonen dat de chip veel verschillende machine-learning-taken uit kan voeren, zoals het herkennen van (onduidelijke) plaatjes van Griekse letters en die vervolgens classificeren.

Een andere test bestond uit het vormen van een efficiënt netwerk met zo min mogelijk kunstmatige neuronen voor het uitvoeren van een specifieke taak. Het netwerk moet dit zelf leren.

De laatste taak die de memristor moest uitvoeren, was het leren herkennen van problemen in ongeclassificeerde mammografie-testscores. Het neurale netwerk moest zelf uitvinden wat belangrijke aanwijzingen waren in de scores en vervolgens aan kunnen duiden wat niet-kwaadaardige en kwaadaardige tumoren waren.

Het volgende doel is de chip zelf sneller maken en het bouwen van arrays van de chips.

Interesant verhaal,

Die memristor dingen klinken een beetje als een verre familie van fpga’s.

Maar berekeningen analoog uitvoeren ? ja dat kan uiteindelijk heel snel zijn maar het is wel even terug naar technologie van before the 70’s.

Ben benieuwd wat het gaat worden