Geluidsgolven om de omgeving mee in de gaten te houden. Het is geen nieuw idee, maar om daadwerkelijk te weten wanneer iemand iets doet, zoals vallen, daar is wat extra kunstmatige intelligentie voor nodig in de vorm van een convolutional neural network.

Met zo’n convolutional neural network of CNN is het mogelijk geluid exact te lokaliseren en te identificeren wat er met een specifiek object gebeurt. Hoe dat precies werkt, beschrijven de Chinese onderzoekers van de Wuhan University of Technology in detail in het tijdschrift Applied Physics Letters.

Grid

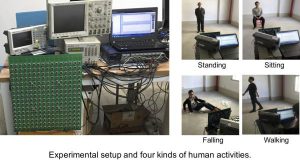

Om die herkenning te bereiken, gebruikten de onderzoekers een tweedimensionaal akoestisch array van 256 ontvangers in een grid van zestien bij zestien en vier ultrasone zenders. Met de verkregen data detecteerden de onderzoekers vier verschillende menselijke activiteiten: staan, zitten, lopen en vallen. Een signaal van veertig kilohertz werd gebruikt om eventueel vervuiling van omgevingsgeluiden weg te filteren.

In de testopstelling konden de onderzoekers met 97,5 procent precisie bepalen wanneer een persoon ging zitten, staan, liep of viel. Dit resultaat kon overigens niet verkregen worden met minder ontvangers, in een grid van acht bij acht of vier bij vier.

De tests werden uitgevoerd met meerdere vrijwilligers die in lengte en gewicht van elkaar verschilden. De vier activiteiten die ze moesten uitvoeren, deden ze op twee meter van het akoestisch array. Van elke vrijwilliger werden tien datasets samengesteld.

Geluidscamera

Met zo’n akoestisch array krijg je een soort van ‘geluidscamera’ en wellicht wordt het in de toekomst mogelijk heel exact te bepalen hoe de wereld eruit ziet zonder de noodzaak van een camera met beeldsensoren.

Geluidsdata worden in Nederland al enige tijd toegepast in uitgaansgebieden en bij andere smart-cityoplossingen om overlast te detecteren, zoals door het Eindhovense bedrijf Sorama.