Een waarheid als een koe: de cloud heeft impact op het ontwerp van datacenters. Maar hoeveel impact eigenlijk, is het meer dan een facelift? Jazeker, het gaat om een fundamentele impact: niet het ontwerp van de infrastructuur verandert, ook het implementatieproces. En dat werd hoog tijd.

Al vanaf het eerste mainframe roepen bedrijven dat ze betere Iitondersteuning voor hun business willen. Nu reactiesnelheid, kosten en het maximaliseren van de kansen belangrijke punten van zorg zijn, kijken bedrijven opnieuw naar de waarde van it. Met de toenemende mobiliteit, consumerization van it en de vraag van lijnmanagers die technisch goed onderlegd zijn, staan it-afdelingen onder druk om proactiever te worden. Bijvoorbeeld door het gebruik van de it-middelen beter op elkaar af te stemmen en om de operationele kosten laag te houden.

En dan is daar de cloud die de waarde van it voor bedrijven op een hoger plan heeft gebracht, compleet met beloften voor de dagelijkse praktijk en met antwoorden op vragen naar de betere afstemming op behoeften van de business. In plaats van software te ontwikkelen en hardware aan te schaffen, heeft de it-afdeling nu de vrije teugel om de business te voorzien van wat zij nodig hebben en wanneer zij dat nodig hebben. En daar kunnen ze voor terecht bij een groot aantal aanbieders van clouddiensten.

De allure van de cloud zorgt ervoor dat er nu opnieuw naar het datacenter moet worden gekeken. Maar om dat datacenter om te bouwen tot een cloud datacenter is nog niet zo eenvoudig. Op basis van mijn ervaringen heb ik de volgende tips:

1) Standaards, standaards, standaards

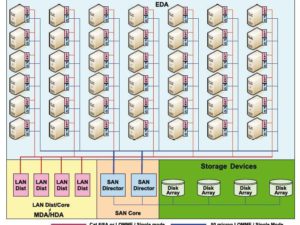

Nog niet zo lang geleden waren datacenters massieve gebouwen vol met kabels en torenhoge racks met oplossingen van allerlei leveranciers. Het doel was simpel: gecentraliseerde opslag met een betere databeveiliging. Maar regelmatig toevoegen van datacentercomponenten van verschillende leveranciers heeft het beheer moeilijk gemaakt, terwijl de operationele kosten uit de hand lopen. De it-afdeling moest de expertise verwerven om al die verschillende componenten te beheren.

Het toevoegen van nog een rack werd zo een ingewikkelde toestand. Bovendien, je weet niet hoeveel opslag je eigenlijk nodig hebt, de bekabeling levert hoofdbrekens op en dan zijn er ook nog issues met koeling en integratie. Dat betekende vooral tijdverlies, tijd die de business had kunnen gebruiken om nieuwe kansen te benutten en de resultaten op te krikken.

De cloud vraagt om standaardisatie en kan de grote normalisator zijn. Nu veel bedrijven in hun datacenter een private cloud implementeren, moeten hun it-afdelingen steeds meer vertrouwen op standaardcomponenten om flexibel aan de vraag van de business te kunnen voldoen.

2) Bespaar niet op prestaties en betrouwbaarheid

Het zal niemand verbazen dat cloud datacenters ontworpen moeten worden rondom prestaties en betrouwbaarheid. Downtime of problemen met de prestaties verstoren de business, wat tot schadeclaims kan leiden en het vertrouwen onder druk zet. Met dat in het achterhoofd is de China Merchant Bank op zoek gegaan naar een zeer goed presterend netwerk dat meer dan tien jaar meekan, ter ondersteuning van de essentiële online dienstverlening. Na een uitputtende zoektocht koos de bank voor een oplossing met koper en multimode glasvezel voor een end-to-end snelheid van 10 Gigabit. En, niet te vergeten, twintig jaar garantie.

3) Ga aan de slag met Dcim

Datacenter infrastructure management (Dcim) staat nu sterk in de belangstelling. Marktvorser Markets and Markets zegt dat Dcim zal uitgroeien tot een enorme business en dat de markt zal groeien van 307 miljoen dollar in 201 tot een gigantische 3,14 miljard dollar in 2017, een jaarlijkse groei van bijna 50 procent. Er wordt zelfs beweerd dat Dcim het woord ‘downtime’ uit het it-vocabulaire zal doen verdwijnen. Wie weet.

Dcim begint met netwerkintelligentie en die intelligentie begint weer op het niveau van de componenten. Zo beschikken geavanceerde panelen over een traceerknop en een led voor elke poort, terwijl in de volgende generatie panelen, de polariteit automatisch gedetecteerd en doorgegeven wordt aan de beheersoftware.

Vraag het de financiële gigant CITIC Securities. Dit bedrijf maakt gebruik van een zeer goed presterende flexibele netwerkinfrastructuur om de grote vraag vanwege de snel groeiende Chinese economie, te kunnen bijhouden.

4) Kies de juiste leverancier

Nog een open deur? Toch niet: het bouwen van een cloud datacenter vereist niet alleen jaren ervaring maar ook de juiste expertise. Nu vraagstukken rond data en privacy en infrastructuur-issues belangrijke punten van aandacht zijn geworden, is het kiezen van de juiste leverancier voor de cloud belangrijker dan ooit, Daar komt bij dat de leverancier ook solide toekomstplannen moet hebben en de financiële middelen om de komende jaren ondersteuning te blijven geven.

Maar er is nog meer nodig dan expertise en ervaring. Zo is het erg belangrijk dat de leverancier de juiste voorraden heeft op de juiste locatie, een punt dat bij internationale projecten maar al te vaak over het hoofd wordt gezien. De leverancier waar CITIC Securities uiteindelijk voor heeft gekozen was is staat om dertienduizend kratten met kabels en bijbehorende apparatuur te leveren die binnen een week op de site nodig waren om de projectdeadline te kunnen halen.

Conclusie

Ontwerpen van datacenters betekent voor de it-afdeling een verfrissende blik op hun huidige inrichting. Het doel is niet veranderd – het bouwen van een efficiënt datacenter dat perfect is toegesneden op de behoeften van de business en de doelstellingen van de business ondersteunt. Als ‘on demand' beschikbaarheid wordt gevraagd, zijn betrouwbaarheid en prestaties cruciaal voor succes. Dat betekent dat er zeer goed gekeken moet worden naar de manier waarop de verschillende componenten worden geïmplementeerd en naar wie deze implementaties uitvoert. Cloud datacenters gaan verder. Zij bieden it de kans om gezien te worden als profit centers die de business ook echt mogelijk maken, in plaats van de business alleen maar ondersteunen.

Beste Jan,

Leuk artikel maar helaas met een korte levensduur!

Veel zaken die je benoemd hebt in je artikel zijn binnenkort niet meer geldig. Het bouwen van een datacenter gaat fundamenteel veranderen. De nieuwe generatie datacenter is een dynamisch datacenter. De meeste punten die je benoemd hebt worden in dit concept geautomatiseerd en dynamisch aangeboden. Hoge optimalisatie, efficiëntie en flexibiliteit zijn bouwstenen van de “next gen datacenter”

In het oude concept maak je gebruik van blades en racks terwijl de volgende generatie is gebaseerd op HyperScale servers. Leveranciers zoals Dell en HP zijn al bezig met het opzetten van dit soort datacenters voor hun klanten. Misschien zijn nu grote bedrijven zoals Microsoft, Google of Amazon de afnemers van dit soort datacenters maar deze oplossing gaat steeds meer richting MKB, het is een kwestie van tijd.

Dus beste datacenterarchitect, Cloud gaat jouw functie ook raken! Plan snel een update-cursus in.

@Reza

ik ga deels mee met je reactie, maar een aantal zaken zoals jij die voorstaat zijn in werkelijkheid anders:

1. Dynamisch datacenter.

Alles in een datacenter is dynamisch, het gebouw of de ruimte is zo statisch als het maar zijn kan. Je zal zeer goed moeten plannen en rekening houden met de komst van andere typen servers, lager opgenomen vermogen per processor,grotere verwerkingskracht en meer processoren per vierkante meter. Je flexibiliteit zal altijd worden beperkt door de fysieke omgeving bestaande uit stenen, racks en toegevoegd koel- en electrisch vermogen.

2. Hyperscale servers is een nieuwe generatie servers waar de density in rekenkracht per meter sterk toeneemt, als het goed is bij gelijkblijvende of afnemend opgenomen vermogen. Je moet deze apparatuur nog steeds plaatsen en door de teogenomen kracht zal er noodzaak zijn aal snelle netwerkverbindingen en snelle access naar Storage. Deze laatste faciliteiten zijn niet zo flexibel en dynamisch als wordt gedacht. Dat ligt aan de architectuur van de geplaatste apparatuur.

3. Ook voor cloud oplossingen moeten datacenters worden gebouwd en het is jammer dat het verhaal Jan niet aangeeft hoe je daar mee om zou moeten gaan. het meest lastige is dat je juist niet op bestaande behoeften van de organisatie of business moeten bouwen, maar op de toekomstige en dat je daarbij rekening moet houden met de transitie van technologie in de komende jaren.

Willem,

Een dynamisch datacenter is een Cloud datacenter waar de datacenterzaken anders(lees flexibel, geautomatiseerd en rekbaar) ingericht zijn.

Met het vervangen van je servers zoals je in punt 1 benoemd heb, heb je geen dynamisch datacenter.

Waar is Cloud op gebaseerd? Zoals je weet, op virtualisatie. Virtualisatie is ook tot datacenter-managementzaken doorgedrongen, hierdoor is dynamisch datacenter ontstaan. In de huidige datacenters zijn netwerk, storage, servers, applicaties etc al gevirtualiseerd maar het fundament daarvan is nog gebaseerd op traditionele servers en traditionele datacenter-management-tools. De komst van Hyper Scale servers en de nieuwe mogelijkheden maken dit concept anders. Hierdoor kun je de workload van datacenter flexibel laten meegroeien met de behoefte “op dat moment”

Veel datacenter-managementzaken worden eenmalig als processen ingericht om de vraag en capaciteit dynamisch op elkaar te laten reageren. De beschikbare capaciteiten kun je flexibel beschikbaar stellen voor verschillende zaken. Bijvoorbeeld wanneer je netwerk minder druk heeft door dataverkeer wordt de capaciteit automatisch toegekend aan bijvoorbeeld VoIP of iets anders(of omgekeerd). er zijn nog meer zaken die in dit concept flexibel zijn. Dit heeft niet alleen met de komst van HyperScale servers te maken maar wel met het concept in z`n geheel. Het is niet alleen “een ander” type server, het concept in z`n geheel is anders.

Ik vind dat veel onderwerpen die Jan benoemd heeft, zijn gebaseerd op traditionele/huidige datacenters. Deze onderwerpen zijn helemaal terecht maar veel daarvan hebben met de komst van deze ontwikkelingen een kort levensduur

Ik begrijp het verhaal maar deels en sommige opmerkingen totaal niet omdat ik DCIM zie als een proces waarin facility management en IT Service management min of meer in convergeren. Zelfs als je (deels) in de cloud zit blijft namelijk planning, ontwerp, monitoring en rapportage nog steeds noodzakelijk.

Want je kunt misschien de verantwoordelijkheid voor spoorwegennet en treinen uit elkaar halen maar de dienstregeling zal toch gezamelijk opgesteld moeten worden. Daarin moet je niet alleen rekening houden met blaadjes op de rails of bevroren wissels maar ook met gepland onderhoud. En hoe meer treinen je laat rijden hoe complexer dit wordt. Je kunt de oude ‘koploper’- een treinstel dat jaren dienst heeft gedaan – wel vervangen door nieuwe dubbeldekkers maar ze blijven nog steeds op rails rijden en niet altijd op tijd.

Het proces DCIM omvat dan ook oude bekenden als: Capacity-, Asset-, Change- en System management maar ook nieuwe als Power- en Virtual management. DCIM zal echter pas de nieuwe bron van waarheid worden als er een standarisatie in de overdracht van (beheer)informatie plaats vindt. Zoals Willem al aangeeft neemt inderdaad de rekenkracht per opgenomen Watt toe maar drukken we dit ook nog steeds in verschillende eenheden uit waardoor we nog weleens ‘floppen’ bij het vergelijken van appels en peren.

Net als dat de topsnelheid van een auto nog niet zoveel zegt over de acceleratie ervan op verharde en onverharde wegen. En wie wel eens een powerdip meegemaakt heeft weet dat het in één keer starten van alle machines tegelijk ook geen goede praktijk is. Getallen moet je dus wel op de juiste waarde schatten omdat er ook veel momenten zijn dat een processor gewoon staat te wachten of bezig is met onproductieve arbeid zoals opstarten.

@Reza,

Uiteraard, ik zie niet waar dit artikel jouw mening tegenspreekt. Geautomatiseerd betekent niet noodzakelijk een statisch blok dat slechts kleine wijzigingen toestaat. De mega DC’s waarover je praat zijn inderdaad heel flexibel en geoptimaliseerd om zo efficiënt (goedkoop) mogelijk diensten te kunnen aanbieden. Optimalisatie krijg je niet zomaar. Het begint zoals beschreven, met intelligentie inbouwen en met automatiseren om deze omgeving te kunnen bijhouden. Ook zal er heel veel nieuwe apparatuur nodig zijn die deze hoeveelheid data kan verstouwen. De schaalvoordelen zijn namelijk niet onbelangrijk! Maar inderdaad: MKB-bedrijven zullen hun IT-omgeving ook aanpassen om vervolgens te genieten van de services-omgeving die deze mega DC’s nu al aanbieden.

@Ewout,

DCIM is een manier om de gehele infrastructuur te beheren. Aangezien de facility-omgeving zich meer en meer in de IP-wereld begeeft, zijn de gebruikelijke IT-tools eenvoudig aan te passen aan de wensen van facility management. Het aantal MAC’s (moves, adds and changes) per jaar is een zeer gebruikelijke term in de IT-omgeving. Daarnaast is capacity management voor de DC-manager inderdaad niet langer een som van het aantal netwerkpoorten. Ook koeling en power (en in mindere mate het gewicht) van alle assets moeten nauwlettend in de gaten gehouden worden. Hiervoor bestaan heel veel tools, maar slechts weinig daarvan kunnen ook met de fysieke bekabeling overweg.