Dedicated servers doen gemiddeld 80 procent van de tijd helemaal niets. Dat is precies één van de redenen waarom momenteel de trend verschuift van hardwareservers richting virtuele oplossingen. Als directielid voor technologie en innovatie houd ik me al jaren bezig met de virtualisatie van datacenters. Die virtualisatie is niet van vandaag of gisteren: jarenlange ontwikkelingen gaan aan de huidige stand van zaken vooraf. In dit artikel beschrijf ik vier verschillende stappen in de ontwikkeling van virtualisatie.

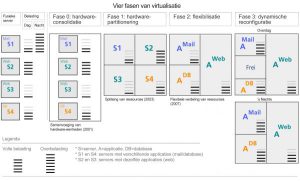

Sinds het eerste gebruik van virtualisatie onderscheid ik vier fasen. In de virtualisatiegrafiek geef ik deze ontwikkeling ook grafisch weer. In 2001 begon het met een pure hardwareconsolidatie, die ik fase 0 noem. Het motto was destijds: bladeservers. De achterliggende gedachte was om hardware-eenheden samen te voegen.

Fase 0

Het proces laat zich goed uitleggen door middel van een voorbeeld. Neem een willekeurige middenstander in gedachten met vier diensten, zoals de illustratie aantoont. Stel dat dit bedrijf een dedicated mailserver heeft, een server voor hun database en twee webservers. Door de hardwareconsolidatie worden de voormalige servers S1, S2, S3 en S4 in één enkele kast met meerdere polen – zogenaamde blades – samengebracht. Het samenbrengen van de hardware brengt naast kostenbesparing tevens een plaatsbesparing met zich mee. In deze fase blijft het energieverbruik overigens nog op hetzelfde niveau.

Fase 1

In Fase 1 (hardwarepartitionering) worden de krachigste servers – zonder blades – naar ressourcen gesplitst, als het ware met een eenvoudige hardwareinstelling. Eén computer wordt op die manier in vier servers verdeeld. Besturingssystemen worden op één fysieke machine samengebracht, en niet meer zoals in fase 0 op vier hardwareplatformen. Dat brengt niet alleen een hardwarebesparing, maar bovendien ook een daling in het stroomverbruik. Administratoren beheren echter nog wel steeds vier servers, ook al liggen die in virtuele containers. Het brengt geen verlichting in het onderhoud van de servers.

Fase 2

Met flexibilisering (Fase 2) kwomt een einde aan het denken in serverdelen. Applicaties en diensten zijn de trefwoorden in deze fase. Er worden niet meer vier servers in één server ondergebracht, maar met software wordt een server flexibel ingericht. In plaats van vier verschillende serverdelen, bestaan slechts nog een mail-, database- en een webapplicatie (die laatste met dubbele ressources). Dat betekent besparing op het gebied van plaats (de grootte van de serverruimte) en hardware (het aantal machines) en bovendien ook op de administratieve rompslomp. Het onderhoud bestaat immers slechts nog uit drie systemen.

Fase 3

Bij dynamische reconfiguratie (Fase 3, tevens de laatste fase), die inmiddels bij verschillende gebruikers standaard is geworden, voert flexibele ressourcenverdeling uit de tweede fase de boventoon. Al naar gelang de belasting hoger is, wordt de server naar een passend vermogen ingedeeld. Dat betekent dat elke toepassing parallel aan de andere draait en slechts het vermogen vraagt dat op dat moment nodig is. Bij een behoefte die plotseling hoger is, grijpt het systeem terug op het vermogen dat op dat moment onbelast is.

Ik illustreer het weer met een voorbeeld uit de illustratie: wanneer de mailserver ‘s nachts door een golf van spam overbelast raakt, grijpt deze terug op het vrije vermogen van de server. Daarmee voorkomt de server een eventuele overbelasting en brengt zo een benutting tot stand die gemiddeld en daardoor het meest efficiënt is.

Conclusie

Het grote voordeel van deze oplossing is dat je slechts nog die ressourcen aanschaft die gemiddeld nodig zijn, niet meer die in piektijden vereist zijn. Je betaalt dus slechts voor het vermogen dat je daadwerkelijk nodig hebt, maar bezit desalniettemin de volledige controle over het besturingssysteem.

René Wienholtz, cto Strato

Goed verhaal, maar er zit wel een addertje onder het gras wat men (in mijn ogen) niet moet vergeten.

Door alles de virtualiseren en op één zware fysieke machine te draaien creëer je een overduidelijk single point of failure.

Even gebruik makend van het voorbeeld van de auteur:

Als in het eerste scenario de web- of databaseserver uitvalt, kun je in ieder geval nog een mailtje sturen om de gebruikers op de hoogte te stellen.

In het laatste scenario kun je helemaal niets meer als de server uitvalt.

@PaVaKe

Dat valt wel mee. Meestal draait dat soort hardware redundant of in een farm of cloud (geef het maar een naam). Tegenwoordig kan men zelfs ‘hot’ switchen van een machine naar een andere zonder al teveel nare bijeffecten.

Virtualisatie stelt je in staat om t snijverlies van de hardware op te vangen. Ideaal dus.

Wat je wel ziet in veel datacenters, is dat de belasting vooral in de nacht optreed. De traditionele backup en update methodes eisen de resources op. Daar zijn natuurlijk al wel oplossingen voor, maar het duurt een tijd voordat iedereen die heeft geïmplementeerd.

Het komt op mij over alsof onder de virtualisatie in fase 3 alleen het virtueel geheugen en multitasking dat standaard in elk serieus te nemen besturingssysteem zit verstaan wordt. Alleen in fase 1 zie ik virtuele machines (VMware of zo) een rol spelen. Mis ik iets of wordt hier inderdaad het woord virtualisatie voor het *niet* gebruiken van VM’s gebezigd?

Als ik dit goed zie wordt enkel een opzet met één taak per server (fysieke machine met één instantie van een besturingssysteem) naar meerdere taken per server beschreven, met een omweg via virtuele machines.

Of heb ik iets gemist?