Na Google komen nu ook Microsoft en Yahoo! met online tools voor het analyseren van webverkeer. Hoewel web analytics daarmee een commodity is geworden, betekent dit geenszins het einde van de klassieke software voor webstatistieken.

Technisch gezien zijn er twee verschillende manieren om bezoekers van een website en hun surfgedrag te analyseren. De eerste maakt gebruik van de log files van de webserver. Dit is een methode die vooral webmasters toepassen. De tweede maakt gebruik van actieve scripts die in de webpagina's zijn verwerkt. Deze methode levert informatie op die marketeers meer zal aanspreken.

Webstatistieken

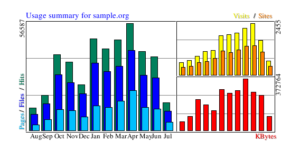

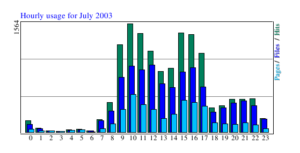

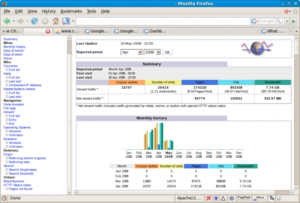

Webalizer is onder webmasters zonder meer de bekendste tool, omdat deze standaard bij Linux-distributies wordt meegeleverd. Ondanks de naam is het geen analyse-tool, maar levert het statistieken van het webverkeer. Denk daarbij aan het aantal bezoekers en bezoeken, waar deze vandaan komen, welke pagina's (URL's) het meest worden bezocht, welke bestanden (hits) het meest worden gedownload, de hoeveelheid verstuurde data, en wat voor soort browser en besturingssysteem (user agent) de bezoeker gebruikt.

De Webalizer-software zelf wordt al meer dan vijf jaar niet meer onderhouden, maar er zijn diverse afgeleiden beschikbaar. Bekende zijn WebDruid, Stone Steps en AWFFull (A Webalizer Fork, Full o' features!). Deze breiden de basisfunctionaliteit van Webalizer uit met zaken als de paden die de gebruikers over de website afleggen, de strings die gebruikers op een zoekmachine intypten, de tijd die men op verschillende pagina's doorbrengt, en de integratie met GeoIP voor een nauwkeurige bepaling van de locatie van de bezoeker.

Een alternatief voor Webalizer is AWStats. De configuratie vraagt net een tikje meer werk, maar het is recenter en completer. Ook W3Perl is een goed alternatief.

Log files

Statistiekprogramma's zoals Webalizer en AWStats maken geen onderdeel uit van de webapplicatie of -server, maar analyseren de log files die de webserver genereerd. Omdat HTTP een stateless protocol is (elke web-pagina staat in principe op zichzelf), is echt sessiebeheer echter niet mogelijk. Zo delen gebruikers achter een firewall vaak hetzelfde IP-adres (via Network Address Translation, NAT). En gaat het om thuisgebruikers of werknemers in een moderne kantooromgeving, dan kan hun adres elke keer weer anders zijn (een dynamisch IP-adres via DHCP).

Je kunt deze problemen omzeilen door cookies te gebruiken. Dat zijn kleine door de webserver gegenereerde bestandjes die identificatie- en sessie-informatie bevatten. Ze worden door de client opgeslagen en weer meegestuurd bij het volgende bezoek aan of de volgende klik naar diezelfde site. Omwille van hun privacy worden cookies door veel gebruikers echter uitgeschakeld.

Gaat het om de tijd die gebruikers op een bepaalde pagina doorbrengen, dan wordt het nog lastiger. Je weet immers alleen wanneer die pagina is opgehaald door de browser van de gebruiker. Niet of hij inderdaad kijkt en of hij in de tussentijd misschien een extra venster of tabblad heeft geopend om andere pagina's te bezoeken. Bovendien krijg je geen bericht meer als een pagina wordt gesloten. Van de laatste pagina heb je dus helemaal geen idee of die is echt is bekeken en hoe lang.

Crawlers

Tenslotte is er nog het probleem van de gebruiker. Het is namelijk lang niet altijd mogelijk om te zien of het om een echt mens gaat, of wellicht om een spider of een bot. Bekende zijn natuurlijk Googlebot, MSNBot en Yahoo Slurp, de robots die web-pagina's downloaden voor indexering in de zoekmachines.

Maar er zijn ook crawlers die RSS feeds indexeren (Google Feedfetch), inbreuk op merken- en auteursrecht in de gaten houden, complete websites kopiëren, en zelfs bots die alleen een commerciële url (vergelijk spam) in de referer logs willen achterlaten.

Alles bij elkaar gaat het om honderden verschillende bots. En juist die automatische bezoekers die je liever niet op je site zou willen zien, doen zich vaak voor als standaard Windows/IE-systemen en houden zich niet aan de robots.txt-conventies. Daarnaast zijn er nog andere bezoekers die je eigenlijk niet of juist apart zou willen tellen. Denk aan RSS readers, of aan de eigen onderhouds-scripts voor bijvoorbeeld advertentie-management en search engine.

Voor de crawlers die zich wel aan de regels in robots.txt houden, helpt een eerste hit op dat tekstbestand om die bezoekers als zodanig te identificeren. De herkenning van robots en search queries is ook precies de reden waarom een oude versie van Webalizer niet goed bruikbaar meer is: er komen steeds nieuwe crawlers en formaten bij.

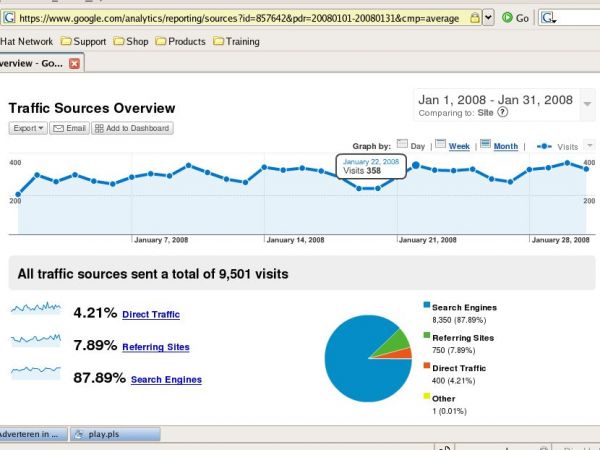

Online analytics

De problemen om op basis van de log-bestanden sessies te onderscheiden, maakt dat veel mensen zo blij zijn met Google Analytics, een online applicatie die ook weer gratis beschikbaar is. Deze tool werkt echter fundamenteel anders dan de eerder besproken software: het heeft geen log files nodig maar volgt de bezoekers via een JavaScript-functie die de webmaster in de pagina's verwerkt. Meestal kan dat in één keer worden gedaan door een include op te nemen in de standaard footer.

Gebruikers zien daar verder niets van, maar elke keer dat een pagina wordt opgevraagd, worden via die JavaScript-functie de gegevens van de bezoeker aan Google doorgegeven. Die verwerkt al die gegevens vervolgens (min of meer real-time) tot statistieken.

Deze manier van werken levert informatie op met veel meer details over de bezoekers en hun gedrag. Zo weet je nu bijvoorbeeld ook de scherm-resolutie van hun pc en het aantal kleuren dat hun computer ondersteunt. Maar veel interessanter is de integratie met AdWords. Je kunt nu bijvoorbeeld zien hoeveel verkeer daarvandaan komt. Bovendien kun je deze informatie combineren met channels, zodat je kunt zien hoe je AdWords-campagnes renderen.

Conversie

Daaraan gerelateerd zijn goals en funnels. Een goal is een pagina waarop bezoekers uiteindelijk uit moeten komen, bijvoorbeeld na hun registratie, bij het completeren van een transactie of bij de aanvraag van meer informatie. Door daarbij een funnel te definiëren (een pad naar een goal) kun je analyseren waar gebruikers afhaken en hopelijk achterhalen waarom.

Nieuw is de benchmarking tool, waarbij je eigen statistieken worden afgezet tegen die van andere sites in dezelfde markt. Deze mogelijkheid bevindt zich op dit moment in het bèta-stadium.

Het belangrijkste bezwaar van Google's aanpak is dat nu weer alleen de echte browsers geregisteerd kunnen worden. Daarbij mis je bovendien de gebruikers die JavaScript om beveiligingsredenen hebben uitgeschakeld. Al zal dat laatste steeds minder voorkomen in dit Web 2.0 tijdperk waarin meer functionaliteit van de server naar de client wordt verplaatst.

Concurrenten

In navolging van het succes van Google Analytics hebben ook Microsoft en Yahoo! dergelijke diensten in de markt gezet. Microsoft adCenter Analytics (codenaam Gatineau) is op dit moment in bèta. Deze is gebaseerd op de software van het anderhalf jaar geleden overgenomen DeepMetrix en gekoppeld aan het advertentie-systeem van de Live zoekmachine en de MSN-websites. Microsoft maakt daarbij onder andere gebruik van de profielen die ze met Live ID (voorheen Passport) verzamelen en de url's die Internet Explorer opstuurt als onderdeel van de anti-phishing optie.

De collega's van Yahoo! hebben in april aangekondigd Tensa Kit, maker van web analytics-software IndexTools, te kopen. Die software is geavanceerder en meer gericht op marketeers. IndexTools krijgt een koppeling met onder andere het advertentie-netwerk van Yahoo! (Search Marketing). Het merendeel van deze tools wordt gratis aangeboden aan een deel van Yahoo!'s bestaande klanten. Nieuwe accounts worden vooralsnog niet aangemaakt. Verder moeten de gebruikers wel akkoord gaan met de gebruiksvoorwaarden die Yahoo! het recht geven de informatie zelf ook te gebruiken. Vergelijkbaar met Google's model dus.

Google Analytics heeft er dus twee serieuze concurrenten bij. Daarmee zijn web analytics net als web statistics een commodity geworden, gratis voor iedereen die zijn waardevolle bezoekersgegevens met een van de online aanbieders wil delen. Overigens betekent dit zeker niet het einde van de tools voor web statistics. Juist vanwege de grote verschillen tussen de twee, zijn beide onontbeerlijk voor de serieuze web-marketeer.